تکنولوژی در کنار مزایایی که دارد، معایب زیادی نیز داشته است. فناوری دیپ فیک یکی از وجوه خطرناک آن است. از جعل عمیق چه میدانیم؟

دریافت صفحه با کد QR

دریافت صفحه با کد QR

این فناوری هوش مصنوعی، ترسناک و خانمانسوز است!

13 مرداد 1401 ساعت 23:12

تکنولوژی در کنار مزایایی که دارد، معایب زیادی نیز داشته است. فناوری دیپ فیک یکی از وجوه خطرناک آن است. از جعل عمیق چه میدانیم؟

به گزارش مردم سالاری آنلاین به نقل ازگجت نیوز،تکنولوژی در کنار مزایایی که دارد، معایب زیادی نیز داشته است. فناوری دیپ فیک یکی از وجوه خطرناک آن است. از جعل عمیق چه میدانیم؟

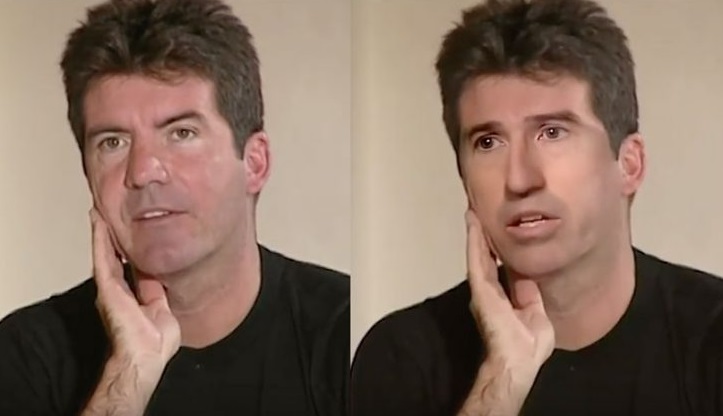

با ظهور و پیشرفت تکنولوژی زندگی مردم دستخوش تغییرات زیادی شد. بخشی از این پیشرفتها به نفع بشریت بوده و برخی از آنها در کنار مزایایی زیاد، معایبی هم داشتهاند. یکی از فناوریهای در حال ظهور دیپ فیک یا جعل عمیق است که افراد طی آن میتوانند ویدیوهایی بسازند که واقعیت ندارند.

فناوری دیپ فیک و تهدیدهای آن

با پیشرفت این فناوری هماکنون کارشناسان ابراز نگرانی کردهاند؛ زیرا محتوایی که در دیپ فیک عرضه میشود، میتواند خطرناک باشد و زندگی افراد را با خطر مواجه سازد. به نظر میرسد این روزها میزان استفاده از دیپ فیک رو به گسترش بوده و همین باعث شده تا کارشناسان نسبت به رشد آن ابراز نگرانی کنند.

دیپ فیک یا جعل عمیق فناوری نوظهوری است که در آن چهره افراد را طوری طراحی میکنند که همه چیز آن واقعی به نظر میرسد. البته از دیپ فیک بیشتر برای افراد مشهور استفاده میشود، ولی ممکن است هر انسانی گرفتار این ویدیوهای دروغین شود. لازم به ذکر است که در این ویدیوهای دروغین و جعلی از تکنیکهایی نظیر هوش مصنوعی استفاده میشود، بنابراین نه تنها چهره افراد بسیار شبیه به واقعیت است، بلکه صدای آنها نیز شبیه است.

در حال حاضر ویدیوهایی که بر پایه این فناوری در تیک تاک در حال انتشار هستند نگرانیهای زیادی را به همراه آوردهاند. در این ویدیوها چهرههای مشهوری نظیر تام کروز، اوباما و بسیاری دیگر از افراد مشهور ساخته شدهاند. تصور کنید فردی با استفاده از این ویدیوها حرف نامربوطی را در دهان رئیس جمهور آمریکا بگذارد و عدهای آن را باور کنند!

همانطور که گفتیم همیشه این ویدیوها درباره افراد مشهور نیستند و حتی افراد عادی را نیز در بر میگیرند. نگرانی کارشناسان این است که سازندگان چنین ویدیوهایی مبادا از آنها در کمپینهای گمراه کننده استفاده کنند. ممکن است از این ویدیوها در کلاهبرداریهای اینترنتی و افترا سوءاستفاده شود. در صورتی که این ویدیوها به صورت گسترده منتشر شوند، میتوانند در اجتماع اختلالات امنیتی ایجاد کنند.

البته نکته امیدوارکننده این است که ساخت چنین ویدیوهایی آسان نیست و نیاز به ابزارها و تجهیزات پیشرفته دارد؛ اما با این حال در آیندهای نه چندان دور این قابلیتها برای همگان قابل دسترس خواهند شد و همچنین برنامههایی به وجود خواهند آمد که میتوان با آنها اقدام به ساخت این ویدیوها کرد.

دیپ فیک چه خطراتی دارد؟

برخی از مشکلاتی که ممکن است دیپ فیک ایجاد کند شامل جعل اخبار نادرست و انتشار آنها، بیاعتبار کردن برخی از افراد مشهور و حتی تهیه پورنوگرافی با چهره افراد میشود. در هر حال میتوان گفت خطرناکترین استفادهای که از جعل عمیق یا دیپ فیک میشود، مربوط به بدنام کردن افراد است.

در سال ۲۰۱۹ یکی از موسسههای نرم افزاری اعلام کرد از ۱۴ هزار ویدیویی که توسط دیپ فیک ساخته شده، حدود ۹۶ درصد مربوط به فیلمهای پورنوگرافی بوده و برای ساخت چنین فیلمهایی از برنامههای رایگان بهره گرفته شده است. انگیزه سازندگان این ویدیوها باجگیری یا انتقام گرفتن بوده است.

از دیگر استفادههای خطرناک دیپ فیک، کلاهبرداری است. ممکن است روزی یک پیام ویدیویی از دوستان یا همکاران خود دریافت کنید که در آن از شما درخواست مبلغ مشخصی پول کنند. در سال ۲۰۲۰ کلاهبرداریهای هویتی از دیپ فیک حدود ۲۰ دلار هزینه برای موسسههای آمریکایی داشته است.

شرکت متا که فیسبوک را در اختیار دارد در سال ۲۰۱۹ تصمیم گرفت ویدیوی نانسی پلوسی را که توسط دیپ فیک ساخته شده بود، در فیسبوک نگه دارد و البته بابت این قضیه مورد سرزنش قرار گرفت. همچنین در سال ۲۰۲۰ بود که توییتر تصمیم گرفت جلوی انتشار هر گونه ویدیوی دیپ فیک را بگیرد، زیرا ممکن است کاربران را فریب دهد یا گیج کند. در همین راستا تیک تاک هم قصد برخورد با منتشرکنندگان را دارد.

کد مطلب: 170687