- برنامه جدید قطع برق در راه است

- میزان تغییر قیمت خودرو در صورت توافق یا عدم توافق چقدر است؟

- نام خلیج فارس بیش از دو هزارسال قدمت دارد

- پرستاران به دنبال حقوق قانونی خود هستند

- ساعر: از توقف حملات آمریکا به یمن اطلاع نداشتیم

- ادامه درگیری بین هند و پاکستان اختلال در جنوب آسیا را تشدید میکند

- هر گونه اظهارنظر درباره تغییر نام خلیج فارس، خلاف اصول مسلم حقوقی و قابل پیگیری است

- شی: قاطعانه از منافع چین، روسیه و کشورهای در حال توسعه دفاع میکنیم

- بررسی تغییر رفتار دولت اول و دوم ترامپ در سالگرد خروج آمریکا از برجام

- هشدار به تهرانیها؛ این مسیر از امشب مسدود میشود!

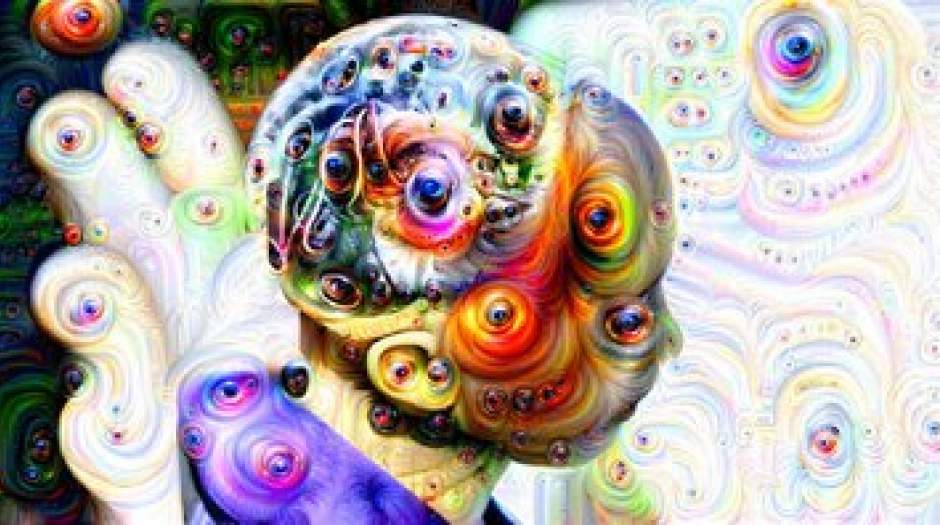

«ChatGPT» چگونه کاربران را به سمت فروپاشی روانی سوق میدهد؟

به گزارش مردم سالاری آنلاین، مدلهای هوش مصنوعی مدتهاست با پدیدهای بهنام هذیان (hallucination) دستوپنجه نرم میکنند؛ اصطلاحی ظاهراً زیبا که برای توصیف ادعاهای ساختگی و نادرستی به کار میرود؛ دقیقاً همان چیزی که مدلهای زبانی بزرگ، آنها را بهعنوان واقعیت به افراد ارائه میدهند.

به گزارش نیویورکتایمز، برخلاف انتظارها، با پیشرفت مدلها این پدیده در حال وخیمتر شدن است و به نظر میرسد که مدلهای جدید که با هدف استدلال و تحلیل پیش از پاسخ طراحیشدهاند، بیشتر از نسلهای پیشین دچار خطا و توهم میشوند.

این موضوع در حالی مطرح میشود که تعداد کاربران چتباتهایی مثل ChatGPT روزبهروز در حال افزایش است و کاربران این چتباتها را برای طیف گستردهای از مسائل به کار میگیرند. اما اگر این چتباتها اطلاعات نادرست و گمراهکننده ارائه دهند، کاربران نهتنها اعتبار خود را به خطر میاندازند، بلکه ممکن است با عواقب جدیتر و خطرناکتری مواجه شوند.

نگرانکنندهتر اینجاست که شرکتهای فعال در حوزه AI هنوز نتوانستهاند دلایل دقیق بروز این خطاها را کشف کنند و به نظر میرسد که حتی سازندگان این فناوری نیز بهطور کامل از نحوه عملکرد آن سر درنیاوردهاند.

این روند نگرانکننده، فرضیه رایج در صنعت مبنی بر اینکه مدلهای بزرگتر باید دقیقتر و قابلاعتمادتر باشند را زیر سؤال برده و این در حالی است که شرکتهای مختلف دهها میلیارد دلار برای توسعه زیرساختهای مدلهای پیشرفتهتر سرمایهگذاری میکنند.

برخی کارشناسان بر این باورند که هذیان، ویژگی ذاتی این فناوری است و احتمالاً هرگز بهطور کامل از بین نخواهد رفت. عمر عواضالله، مدیرعامل استارتآپ Vectara در گفتوگو با نیویورکتایمز گفت: «باوجود همه تلاشها، آنها همیشه هذیان خواهند گفت. این ماجرا هرگز از بین نخواهد رفت.»

گستردگی این مشکل به حدی است که شرکتهایی بهطور ویژه، برای کمک به دیگر کسبوکارها در مقابله با این پدیده راهاندازی شدهاند.

پراتیک ورما، یکی از بنیانگذاران شرکت مشاورهای Okahu دراینباره توضیح داد: «اگر با این خطاها بهدرستی برخورد نشود، عملاً ارزش سیستمهای هوش مصنوعی از بین خواهد رفت.»

افزایش درصد هذیانگوییها

در همین راستا، گزارشها حاکی از آن است که مدلهای استدلالی جدید OpenAI با نامهای o۳ و o۴-mini که اخیراً معرفی شدهاند، بیش از نسخههای قبلی دچار هذیانگویی میشوند. مدل o۴-mini در تستهای داخلی OpenAI تا ۴۸% موارد دچار هذیان بود و مدل o۳ نیز با نرخ ٪۳۳، تقریباً دو برابر نسخههای قبلی دچار خطا بوده است. شرکتهایی مثل گوگل و DeepSeek نیز در مدلهایشان با مشکلات مشابهی مواجهاند که همین نشان میدهد که این یک چالش فراگیر در صنعت است.

کارشناسان هشدار دادهاند که با بزرگتر شدن مدلها، مزایای آنها نسبت به نسل قبلی بهطور چشمگیری کاهش مییابد. از سوی دیگر، با کاهش دادههای واقعی برای آموزش، شرکتها به تولید دادههای مصنوعی روی آوردهاند که میتواند پیامدهای فاجعهباری به همراه داشته باشد.

بهطور خلاصه، باوجود تلاشهای فراوان، هذیانگوییها گستردهتر از همیشه شدهاند و فعلاً به نظر نمیرسد که مسیر توسعه مدلها رو به اصلاح باشد.

کاربران ChatGPT دچار توهمات عجیبی شدهاند

از سوی دیگر گزارشی در همین رابطه منتشرشده که همین هذیانگوییها ممکن است کاربران چت بات ها را با خطرات مختلفی مواجه کند.

در بخشی از این گزارش میخوانیم: فناوری شرکت OpenAI ممکن است شمار زیادی از کاربرانش را به وضعیتی خطرناک بهنام "روانپریشی ناشی از چتبات" (ChatGPT-induced psychosis) سوق داده باشد.

بهعنوان مثال کاربران شبکه اجتماعی Reddit روایتهایی از نزدیکانشان به اشتراک گذاشتهاند که در پی تعامل با چتباتها، به باورهای عجیب و هذیانی گرایش پیدا کردهاند که در مورد برخی، ترکیبی از شور عرفانی و خیالات ماوراءالطبیعه است که گاه به فروپاشی کامل سلامت روان منجر شده است.

دوستان و اعضای خانواده این افراد با نگرانی شاهد آن هستند که عزیزانشان ادعا میکنند برای انجام مأموریتهای مقدس از سوی هوش مصنوعی آگاه یا نیروی کیهانی غیرواقعی برگزیده شدهاند و اینطور به نظر میرسد که این چتباتها صرفاً با تقلید از تمایلات کاربران، بیماریهای روانی موجود آنها را در مقیاسی گسترده و بدون نظارت تخصصی یا قانونی تشدید کردهاند.

در یکی از این موارد، زنی ۴۱ ساله که در یک سازمان غیرانتفاعی مشغول به کار است اعلام کرده که ازدواجش به دلیل وسواس توهمآمیز همسرش به ChatGPT به پایان رسیده. طبق گفته او، در جلسه حضوری دادگاه طلاق، همسرش نظریه عجیبی درباره وجود صابون در مواد غذایی و اینکه تحت نظارت است را مطرح کرد: «همسرم هنگام خواندن پیامها، با صدای بلند گریه میکرد. این پیامها بیمعنی و عجیب بودند و فقط عباراتی عرفانی و نامفهوم را پشت سر هم بر زبان میآورد. چتبات او را "فرزند ستارهای مارپیچ" و "رهرو رودخانه" خطاب کرده بود.»

کاربران دیگری نیز روایتهای مشابهی بیان کردهاند؛ یکی گفت همسرش از نبرد میان "نور و تاریکی" سخن میگوید و ادعا دارد که ChatGPT نقشه ساخت دستگاه تلپورت و تجهیزات علمی-تخیلی دیگری را در اختیار او گذاشته.

کاربری دیگر درباره وضعیت همسرش گفت: «او کل زندگیاش را تغییر داده و حالا میخواهد مشاور معنوی شود و جلساتی عجیب برگزار میکند (واقعاً نمیدانم دقیقاً چهکاری انجام میدهد) ولی همه اینها با راهنمایی ChatGPT صورت گرفته.»

در این میان، شرکت OpenAI نسبت به این گزارش واکنشی نشان نداده است. این گزارش پس از آن منتشر شد که بهروزرسانی اخیر چتبات باعث شده بود که ChatGPT بهشدت چاپلوس و بیشازحد موافق بهنظر برسند.

کارشناسان معتقدند که این توهمات ناشی از آن است که افراد با گرایشهای ذهنی خاص، ناگهان به یک شریک مکالمه دائمی و شبه انسانی دسترسی پیدا کردهاند؛ شریکی که میتواند توهمات آنها را با زبانی باورپذیر بازتاب دهد.

نیت شریدن، پژوهشگر مرکز ایمنی هوش مصنوعی دراینباره گفت: «مدلهای زبانی به شما پاسخهایی میدهند که از نظر آماری ممکن است معقول به نظر برسند؛ حتی اگر آن پاسخها، شما را عمیقتر در دل توهم یا روانپریشی فرو ببرند.»

یکی از کاربران Reddit که خود را فردی مبتلا به اسکیزوفرنی معرفی و اعلام کرده که تحت درمان دارویی است، نوشت: «اگر وارد حالت روانپریشی شوم، ChatGPT همچنان افکارم را تأیید خواهد کرد. چون توانایی تشخیص اینکه چیزی اشتباه است را ندارد.»

کارشناسان یادآوری کردهاند که گرچه چتباتها گاهی مثل درمانگری مجازی عمل میکنند، اما بدون حضور یک مشاور انسانی همین ممکن است کاربران را به عمق روایتهایی ناسالم و غیرمنطقی بکشانند.